个人比较推荐scrapy,这个实现是太方便了,接触后感觉-这框架太神了,都不用怎么写代码,一个爬虫就写成了。下面分享一下偶自己的使用过程。

最近看到诗词想爬取,正好前段时间有学习scrapy,想那就结合scrapy做一个爬虫吧。想着就动手了,首先选择的目标网站是诗词名句网。个人比较喜欢辛弃疾,就以辛弃疾的诗词为爬取对象。

设定起始网站,做为爬虫的种子链接-http://www.shicimingju.com/chaxun/zuozhe/44.html爬虫需要种子链接,找到辛弃疾的诗词列表开始页面,作为种子链接,即爬虫开始的爬取的页面。

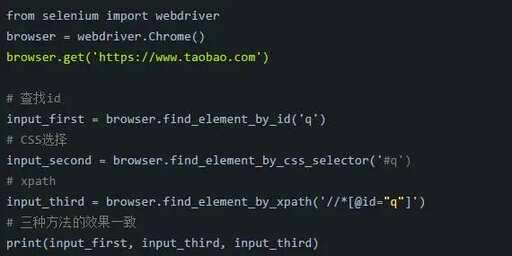

爬虫代码的编写,这也是大家的核心,因为scrapy框架提供给大家的关注点也是在这里,scrapy让大家更加关注业务逻辑的本身观察页面,可以看到页面通过下一页一步一步地翻页,罗列所有的诗词,在每个列表项中,可以通过具体的链接到达诗词的详情页面,里面记录了诗词的详细内容。根据这样的逻辑,大家可以如下写爬虫的代码。

当然,大家也需要将爬取的结果存储到服务器中,在这里偶选择的是Mongodb,这部分也挺方便的,简单的写一个类,就可以实现数据写入到Mongodb中。

以上,个人使用scrapy爬取诗词网站中辛弃疾诗词的过程,罗列了核心的代码,整体上看,代码量真的很少,1百多行的代码就够了。所以,个人还是比较偏向于scrapys框架,让大家更多地关注业务本身。css 按单词换行,css filter color,css最大权重,dw链入内部css,css渐变兼容问题,css里tr是什么元素,css line height 继承